Sempre più spesso ascoltiamo e/o ci vengono proposti questi termini durante riunioni di lavoro utilizzati per distinguere infrastrutture di nuova generazione da infrastrutture tradizionali basate su server farm virtualizzate organizzate per tenant.

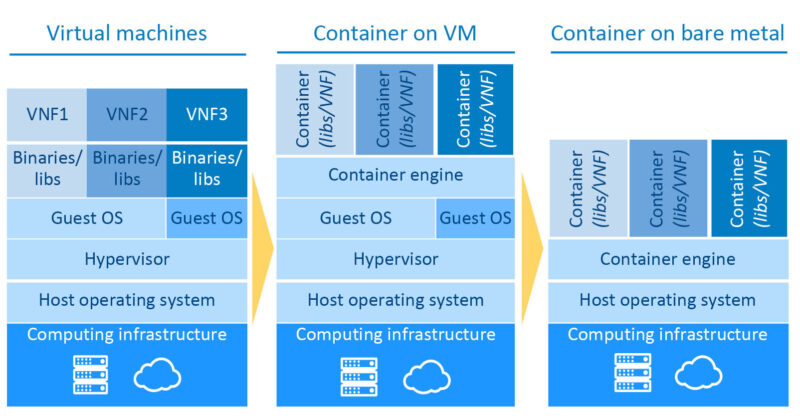

La containerizzazione e l’orchestrazione di container sono tecnologie affermatesi a furor di popolo negli ultimi anni che si basano sulla virtualizzazione a livello di sistema operativo e si differenziano dalla virtualizzazione tradizionale per alcune caratteristiche.

La containerizzazione è una tecnologia che consente di creare e gestire contenitori, ovvero delle unità software che includono tutto il necessario per eseguire un’applicazione. I contenitori sono creati a partire da immagini che contengono il codice dell’applicazione, le dipendenze e le librerie necessarie. Ogni contenitore è isolato dal resto del sistema operativo, ma condivide le risorse del sistema operativo, tra cui il kernel e le librerie condivise. La containerizzazione è più leggera rispetto alla virtualizzazione tradizionale perché i contenitori condividono il kernel del sistema operativo, senza dover virtualizzare l’intero sistema operativo.

Con la locuzione “Containerizzazione on bare metal” si intende l’esecuzione di container direttamente su server fisici, senza l’utilizzo di una virtualizzazione di tipo hypervisor come VMWare o VirtualBox.

In altre parole, quando si utilizza la tecnologia di containerizzazione, i container vengono eseguiti su un sistema operativo ospite condiviso, piuttosto che su un sistema operativo separato e virtualizzato come avviene nella virtualizzazione di tipo hypervisor. Nel caso della “container on bare metal”, i container vengono eseguiti direttamente su server fisici, senza l’utilizzo di un sistema operativo ospite virtualizzato.

Ciò significa che l’esecuzione di container on bare metal è generalmente più efficiente e leggera rispetto all’esecuzione di container all’interno di una macchina virtuale, poiché non ci sono overhead associati alla virtualizzazione.

Tuttavia, l’esecuzione di container on bare metal richiede una maggiore attenzione nella configurazione e nella sicurezza del sistema, poiché i container condividono le risorse del sistema operativo ospite e potenzialmente possono influenzarsi a vicenda. Inoltre, l’esecuzione di container on bare metal richiede una maggiore pianificazione e gestione delle risorse di sistema, poiché i container condividono lo stesso kernel del sistema operativo ospite e possono concorrere per le risorse di sistema come CPU, memoria e storage.

L’orchestrazione di container è invece una tecnologia che consente di gestire e coordinare l’esecuzione di più contenitori su un cluster di server. L’orchestrazione permette di garantire la disponibilità, la scalabilità e la sicurezza delle applicazioni distribuite su un’infrastruttura di container. L’orchestrazione gestisce anche il networking e lo storage dei contenitori.

La virtualizzazione tradizionale consente di creare macchine virtuali che emulano un intero sistema operativo, mentre la containerizzazione consente di creare contenitori che condividono il kernel del sistema operativo. L’orchestrazione di container consente di gestire l’esecuzione di più contenitori su un cluster di server, garantendo la disponibilità, la scalabilità e la sicurezza delle applicazioni. La containerizzazione e l’orchestrazione di container sono tecnologie più leggere e flessibili rispetto alla virtualizzazione tradizionale, rendendole ideali per la distribuzione di applicazioni su ambienti cloud e distribuiti.

Docker, Kubernetes e l’orchestazione di container

Docker e Kubernetes sono due tecnologie molto popolari nell’ambito della containerizzazione e dell’orchestrazione di container.

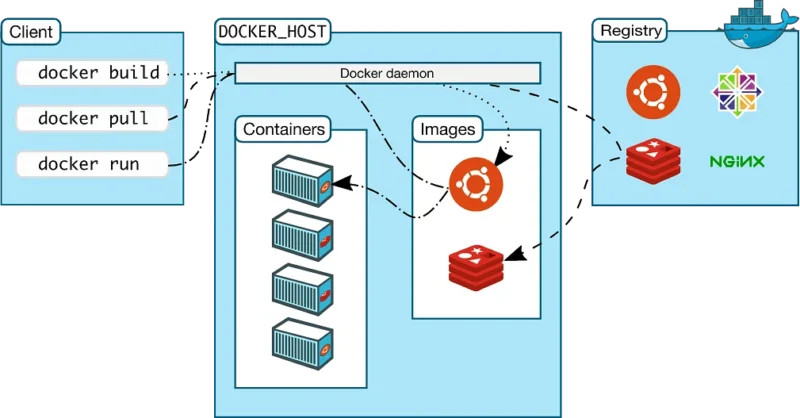

Docker è una piattaforma di containerizzazione che consente di eseguire applicazioni all’interno di container isolati, ciascuno dei quali include tutti i pacchetti e le dipendenze necessari per far funzionare l’applicazione. In questo modo, è possibile garantire che l’applicazione funzioni in modo affidabile e coerente, indipendentemente dall’ambiente di esecuzione. Ad esempio, si possono creare container Docker per eseguire un’applicazione Java, un’applicazione Node.js, un database MySQL e così via.

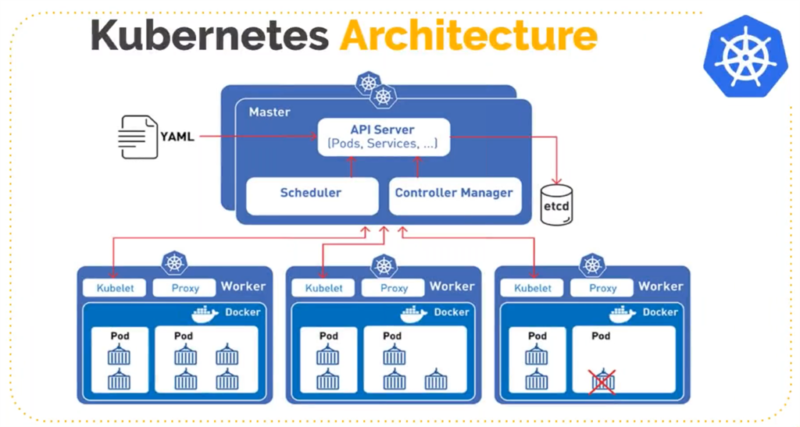

Kubernetes, invece, è un sistema di orchestrazione di container che consente di gestire un grande numero di container Docker in modo scalabile e affidabile. Kubernetes consente di definire un insieme di regole per l’esecuzione di container, come ad esempio la definizione di un numero minimo e massimo di container da eseguire contemporaneamente, o le politiche di failover e ripristino in caso di problemi. Inoltre, Kubernetes consente di gestire in modo dinamico il carico di lavoro dei container, ad esempio aumentando o diminuendo il numero di container in base alla domanda.

Ecco alcuni esempi di come queste tecnologie possono essere utilizzate:

- Un team di sviluppo potrebbe utilizzare Docker per creare un ambiente di sviluppo coerente per tutti i membri del team, in modo da garantire che l’applicazione funzioni correttamente in ogni ambiente di sviluppo. Inoltre, Kubernetes potrebbe essere utilizzato per gestire l’orchestrazione dei container in produzione, garantendo che l’applicazione sia scalabile e disponibile.

- Un’azienda che gestisce una grande quantità di servizi Web potrebbe utilizzare Docker per creare container isolati per ciascun servizio, in modo da garantire la coerenza e l’isolamento dei servizi. Inoltre, Kubernetes potrebbe essere utilizzato per gestire l’orchestrazione dei container, in modo da garantire che i servizi siano scalabili e disponibili.

- Un’organizzazione potrebbe utilizzare Docker per creare un ambiente di sviluppo e test per un’applicazione, e poi distribuire l’applicazione su un cluster Kubernetes in produzione. In questo modo, si garantisce che l’applicazione funzioni in modo affidabile sia durante lo sviluppo che in produzione.

Kubernetes

Kubernetes è un sistema open source di orchestrazione di container che consente di gestire il deployment, la scalabilità e la disponibilità di applicazioni containerizzate. Kubernetes è stato progettato per gestire le applicazioni containerizzate in modo scalabile e resiliente, garantendo che l’applicazione sia sempre disponibile e funzionante, indipendentemente dal carico di lavoro e dai guasti.

Di seguito, ti fornisco maggiori dettagli su alcuni dei principali concetti di Kubernetes:

- Pod: un pod è l’unità minima di distribuzione in Kubernetes. Un pod rappresenta un insieme di uno o più container che condividono la stessa risorsa di rete e di storage. Ad esempio, si potrebbe avere un pod che include un container per un’applicazione Web e un altro container per un database, in modo che l’applicazione possa accedere al database tramite la rete locale del pod.

- Deployment: un deployment è un oggetto Kubernetes che definisce come eseguire e aggiornare una o più repliche di un’applicazione. Ad esempio, si potrebbe definire un deployment che specifica che l’applicazione deve essere eseguita in un pod con due repliche, garantendo che l’applicazione sia sempre disponibile, anche in caso di guasti.

- Service: un service è un oggetto Kubernetes che definisce un punto di accesso di rete stabile per un insieme di pod. Ad esempio, si potrebbe definire un service per un’applicazione che distribuisce il traffico tra i pod in modo bilanciato, garantendo che l’applicazione sia scalabile e disponibile.

- Volume: un volume è un oggetto Kubernetes che rappresenta un’area di storage condivisa tra uno o più container all’interno di un pod. Ad esempio, si potrebbe definire un volume per un database, in modo che i dati siano conservati anche in caso di ripristino del pod.

- Namespace: un namespace è un modo per organizzare gli oggetti Kubernetes all’interno di un cluster. I namespace consentono di separare le risorse in base a progetti, team o ambienti. Ad esempio, si potrebbe avere un namespace per lo sviluppo, uno per la produzione e uno per i test.

Ecco alcuni esempi di come Kubernetes può essere utilizzato:

- Un’azienda che gestisce un’applicazione Web potrebbe utilizzare Kubernetes per distribuire l’applicazione su un cluster di server. Kubernetes consentirebbe di gestire il deployment, la scalabilità e la disponibilità dell’applicazione in modo automatico, garantendo che l’applicazione sia sempre disponibile e funzionante.

- Un team di sviluppo potrebbe utilizzare Kubernetes per creare un ambiente di sviluppo isolato, in cui ogni membro del team ha un proprio cluster Kubernetes. In questo modo, ogni sviluppatore può eseguire l’applicazione in un ambiente isolato, senza interferire con gli altri membri del team.

- Un’organizzazione che gestisce un grande numero di servizi potrebbe utilizzare Kubernetes per gestire l’orchestrazione dei servizi su un cluster di server. In questo modo, Kubernetes consentirebbe di gestire la scalabilità e la disponibilità dei servizi in modo automatico, garantendo che i servizi siano sempre disponibili e funzionanti.

Docker

Docker è una tecnologia di virtualizzazione a livello di sistema operativo che consente di creare, distribuire e gestire applicazioni in contenitori. Un contenitore è un’unità di software che include tutto il necessario per eseguire l’applicazione, tra cui il codice, le librerie e le dipendenze.

Di seguito, maggiori dettagli su alcuni dei principali concetti di Docker:

- Immagine: un’immagine Docker è un pacchetto di software che include tutto il necessario per eseguire un’applicazione in un contenitore. L’immagine contiene il codice dell’applicazione, le dipendenze e le librerie necessarie, nonché le istruzioni su come creare un contenitore.

- Contenitore: un contenitore Docker è un’istanza di un’immagine che viene eseguita su un host. Un contenitore è isolato dal resto del sistema operativo, ma condivide le risorse del sistema operativo, tra cui il kernel e le librerie condivise.

- Dockerfile: un Dockerfile è un file di testo che contiene le istruzioni su come creare un’immagine Docker. Il Dockerfile definisce il sistema operativo, le dipendenze e le librerie necessarie per l’applicazione, nonché le istruzioni su come creare un contenitore.

- Registro Docker: un registro Docker è un servizio in cui vengono archiviate le immagini Docker. Il registro Docker consente di distribuire e condividere le immagini Docker con altri utenti.

Ecco alcuni esempi di come Docker può essere utilizzato:

- Un’azienda che gestisce un’applicazione Web potrebbe utilizzare Docker per creare un’immagine dell’applicazione e distribuirla su un cluster di server. Docker consentirebbe di gestire l’ambiente di esecuzione dell’applicazione in modo isolato, garantendo che l’applicazione sia sempre disponibile e funzionante.

- Un team di sviluppo potrebbe utilizzare Docker per creare un ambiente di sviluppo isolato, in cui ogni membro del team ha un proprio contenitore Docker. In questo modo, ogni sviluppatore può eseguire l’applicazione in un ambiente isolato, senza interferire con gli altri membri del team.

- Un’organizzazione che gestisce un grande numero di servizi potrebbe utilizzare Docker per gestire l’orchestrazione dei servizi su un cluster di server. In questo modo, Docker consentirebbe di gestire l’ambiente di esecuzione dei servizi in modo isolato, garantendo che i servizi siano sempre disponibili e funzionanti.

Inoltre, Docker può essere utilizzato anche per creare ambienti di sviluppo e test, per distribuire applicazioni su cloud pubblici o privati, per semplificare la distribuzione di software in ambienti eterogenei e per ridurre il tempo di deployment delle applicazioni.

Due Parole su Podman

Podman è un software open-source di containerizzazione che consente di creare e gestire i container, così come Docker. Tuttavia, a differenza di Docker, Podman utilizza un’architettura a processo isolato anziché una architettura client-server.

Ciò significa che con Podman non c’è bisogno di un daemon di sistema separato per la gestione dei container, come avviene invece con Docker. Invece, ogni container Podman viene eseguito come un processo separato all’interno del sistema host, che lo rende più sicuro e leggero.

Inoltre, Podman supporta anche la gestione dei pod, che sono gruppi di container correlati che possono essere gestiti insieme come una singola unità logica. I pod sono simili ai gruppi di container forniti da Kubernetes, ma Podman li gestisce direttamente, senza bisogno di un’infrastruttura Kubernetes completa.

Infine, un’altra caratteristica interessante di Podman è la sua compatibilità con Docker. Ciò significa che i container Docker possono essere eseguiti utilizzando Podman, senza dover installare il demone Docker. Inoltre, Podman è in grado di utilizzare le stesse immagini Docker, rendendo la migrazione da Docker a Podman relativamente semplice.

Podman vs Docker

Podman e Docker sono entrambi software di containerizzazione che consentono di creare, gestire e distribuire container. Tuttavia, ci sono alcune differenze significative tra i due.

Una delle principali differenze tra Podman e Docker è l’architettura sottostante. Podman utilizza un’architettura a processo isolato, che significa che ogni container viene eseguito come un processo separato all’interno del sistema host. D’altra parte, Docker utilizza un’architettura client-server, che richiede un daemon di sistema separato per la gestione dei container.

Un’altra differenza importante tra Podman e Docker è la sicurezza. Poiché Podman non richiede un demone di sistema separato, il rischio di attacchi esterni è notevolmente ridotto. Inoltre, Podman utilizza un’infrastruttura di autenticazione e autorizzazione basata su Linux, che rende i container più sicuri.

Inoltre, Podman supporta la gestione dei pod, che sono gruppi di container correlati che possono essere gestiti insieme come una singola unità logica. Docker, d’altra parte, offre la possibilità di gestire i container all’interno di gruppi, ma richiede l’uso di strumenti aggiuntivi come Kubernetes.

Infine, un’altra differenza tra Podman e Docker è la compatibilità con le immagini Docker. Podman è in grado di utilizzare le stesse immagini Docker, il che significa che la migrazione da Docker a Podman è relativamente semplice.

Entrambi sono strumenti di containerizzazione potenti, Podman offre un’architettura più sicura, la gestione dei pod integrata e una maggiore compatibilità con le immagini Docker. Tuttavia, Docker ha una maggiore diffusione e comunità di utenti, nonché un ecosistema più ampio di strumenti e plugin.

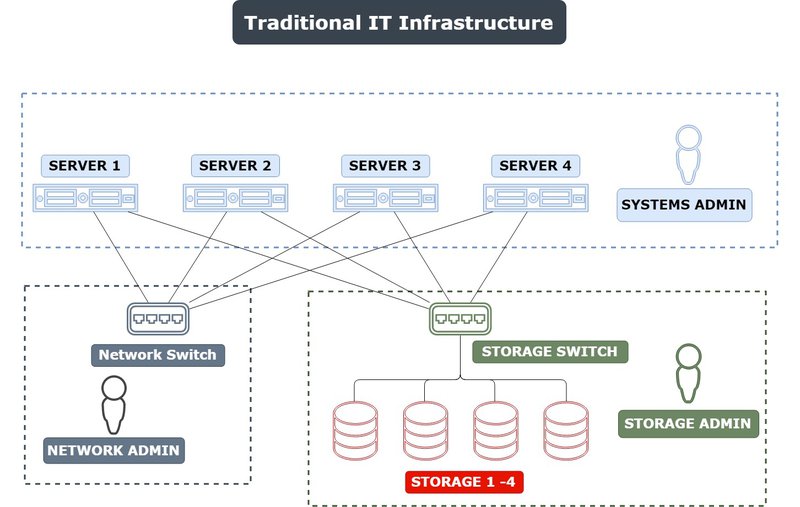

Infrastruttura Tradizionale Fisica e/o Virtualizzata

Possiamo definire “infrastruttura tradizionale” un’infrastruttura IT che viene gestita in modo “on-premises“, ovvero all’interno dei propri locali o data center, senza l’utilizzo di servizi cloud o di tecnologie di containerizzazione.

In una tipica infrastruttura tradizionale, i server fisici, lo storage e il networking vengono acquistati e gestiti internamente dall’azienda, senza l’utilizzo di servizi cloud come quelli offerti da Amazon Web Services (AWS), Microsoft Azure o Google Cloud Platform.

Inoltre, le applicazioni vengono eseguite su server fisici o virtuali che sono installati e gestiti internamente dall’azienda, senza l’utilizzo di tecnologie di containerizzazione come Docker o Kubernetes.

In una infrastruttura IT tradizionale, ci sono diverse piattaforme che svolgono funzioni chiave. Di seguito ti descrivo alcune delle principali:

- Server: i server sono il cuore dell’infrastruttura IT tradizionale. Sono macchine hardware dedicate che eseguono applicazioni, fornendo risorse come storage, memoria e potenza di elaborazione. I server possono essere fisici o virtuali.

- Storage: la piattaforma di storage include hardware e software per l’archiviazione dei dati. Ci sono varie tecnologie di storage disponibili, come il disco rigido (HDD), la memoria flash (SSD) e la tecnologia di storage a blocchi (SAN).

- Rete: la piattaforma di rete include hardware e software per la connessione tra dispositivi, come switch, router e firewall. Le reti possono essere cablate o wireless, e possono includere componenti come VPN, NAT e proxy.

- Virtualizzazione: la virtualizzazione consente di eseguire più macchine virtuali su un singolo server fisico, aumentando l’efficienza e la flessibilità dell’infrastruttura. Ci sono diverse piattaforme di virtualizzazione disponibili, tra cui VMware, Hyper-V e KVM.

- Sistema operativo: il sistema operativo è il software principale che gestisce le risorse del sistema e fornisce l’interfaccia tra le applicazioni e l’hardware. Ci sono diversi sistemi operativi disponibili, come Windows, Linux e Unix.

- Database: il database è una piattaforma software per la gestione dei dati. Ci sono diverse tecnologie di database disponibili, come Oracle, SQL Server, MySQL e PostgreSQL.

- Applicazioni: le applicazioni sono il software che viene eseguito sui server e utilizzato dagli utenti finali. Ci sono diverse tipologie di applicazioni disponibili, come quelle per la gestione dell’ufficio, la gestione delle risorse umane, la gestione della produzione e così via.

Riassumedo, l’infrastruttura IT tradizionale si basa su diverse piattaforme, tra cui server, storage, rete, virtualizzazione, sistema operativo, database e applicazioni. L’integrazione di queste piattaforme è essenziale per la gestione efficace dell’infrastruttura IT.

Le tecnologie di una infrastruttura tradizionale per la gestione delle applicazioni includono principalmente:

- Apache HTTP Server: è un server web open source che consente di distribuire contenuti web. Apache HTTP Server supporta numerosi moduli e plugin, consentendo di estendere le funzionalità del server web.

- Nginx: è un server web open source che consente di distribuire contenuti web. Nginx è noto per le sue prestazioni elevate e la sua capacità di gestire un grande numero di connessioni simultanee.

- MySQL: è un database relazionale open source che consente di gestire grandi quantità di dati. MySQL è noto per la sua affidabilità e le sue prestazioni elevate, ed è ampiamente utilizzato in applicazioni web.

- Apache Tomcat: è un server di applicazioni open source che consente di eseguire applicazioni Java su un server web. Apache Tomcat è noto per la sua facilità d’uso e la sua flessibilità, ed è ampiamente utilizzato per lo sviluppo di applicazioni Java.

- Microsoft Internet Information Services (IIS): è un server web proprietario di Microsoft che consente di distribuire contenuti web su sistemi operativi Windows. IIS è noto per la sua facilità d’uso e la sua integrazione con altri prodotti Microsoft.

- JBoss: è una suite di middleware open source sviluppata dalla società Red Hat. JBoss fornisce un’ampia gamma di strumenti per lo sviluppo, la distribuzione e la gestione di applicazioni Java e Java EE (Enterprise Edition) su piattaforme on-premises o cloud.

- Oracle Server: conosciuto anche come Oracle Database, è un sistema di gestione di basi di dati relazionali sviluppato da Oracle Corporation. È uno dei sistemi di gestione di database più popolari e diffusi al mondo, utilizzato in molte grandi organizzazioni e aziende.

In sintesi, le tecnologie di infrastruttura tradizionale per la gestione delle applicazioni includono Apache HTTP Server, Nginx, MySQL, Apache Tomcat, Microsoft IIS, Oracle Server e JBoss. Queste tecnologie sono state utilizzate per molti anni per gestire le applicazioni su infrastrutture di server tradizionali, e ancora lo sono, prima dell’avvento delle tecnologie di containerizzazione e cloud computing.

Le infrastrutture tradizionali sono state la norma per molti anni e ancora oggi sono utilizzate in molte aziende. Tuttavia, con l’avvento delle tecnologie di containerizzazione e cloud computing, molte aziende stanno iniziando a spostare le loro applicazioni e i loro servizi su infrastrutture cloud o ibride, per sfruttare i numerosi vantaggi offerti da queste tecnologie, come la scalabilità, l’affidabilità e la flessibilità.

La virtualizzazione è una tecnologia che consente di creare macchine virtuali (VM), ovvero ambienti di esecuzione che emulano un intero sistema informatico, compreso il sistema operativo, l’hardware e le applicazioni. La virtualizzazione consente di eseguire più sistemi operativi su un unico server fisico, consentendo di sfruttare al massimo le risorse hardware e semplificando la gestione delle infrastrutture IT.

Nelle infrastrutture di tipo tradizionale, la virtualizzazione viene utilizzata per creare ambienti di sviluppo, test e produzione. Ad esempio, un’azienda potrebbe utilizzare la virtualizzazione per creare un ambiente di sviluppo in cui gli sviluppatori possono lavorare su macchine virtuali isolate senza interferire con il sistema operativo principale della loro workstation.

Un altro esempio di utilizzo della virtualizzazione è la creazione di ambienti di test. In questo caso, i tester possono utilizzare le macchine virtuali per simulare l’interazione degli utenti con le applicazioni e testare la compatibilità e la stabilità dell’applicazione su diverse configurazioni hardware e software.

Infine, la virtualizzazione viene utilizzata anche per creare ambienti di produzione, in cui le applicazioni vengono eseguite su macchine virtuali isolate, consentendo di separare i servizi tra di loro e garantendo una maggiore sicurezza e scalabilità delle applicazioni.

Conclusioni

Quindi riassumendo possiamo affermare che al momento lo stato dell’arte della tecnologia rispetto al tema della containerizzazione si sviluppa seguendo le seguenti Tecnologie.

Tecnologie che permettono la containerizzazione che includono principalmente:

- Docker: è una delle tecnologie più diffuse per la containerizzazione. Docker consente di creare, gestire e distribuire container. Docker utilizza un formato di immagine che include il codice dell’applicazione, le dipendenze e le librerie necessarie.

- Podman: è una tecnologia di containerizzazione leggera, sicura e flessibile, che offre diverse funzionalità interessanti per la gestione dei container e dei pod, oltre a una buona compatibilità con Docker.

- Kubernetes: è una piattaforma di orchestrazione di container open source che consente di gestire e coordinare l’esecuzione di più container su un cluster di server. Kubernetes offre funzionalità avanzate come la scalabilità automatica, il bilanciamento del carico e la gestione del networking e dello storage.

- Apache Mesos: è una piattaforma di gestione delle risorse distribuite che consente di eseguire applicazioni su un cluster di server. Mesos consente di gestire la distribuzione di container su un cluster di server, offrendo funzionalità avanzate come il bilanciamento del carico, la scalabilità automatica e la gestione del failover.

- LXC/LXD: sono tecnologie di containerizzazione basate sul kernel Linux che consentono di creare e gestire container Linux isolati. LXD consente di gestire i container come macchine virtuali, offrendo funzionalità avanzate come la gestione delle immagini e la replicazione dei container.

Queste tecnologie che permettono la containerizzazione includono Docker, Kubernetes, Apache Mesos e LXC/LXD, ognuna di queste offre funzionalità avanzate per la gestione dei container su un’infrastruttura di server distribuiti.

tecnologie per il deployment delle applicazioni. In questo caso, le tecnologie per il deployment delle applicazioni includono:

- Docker Compose: è uno strumento che consente di definire e gestire applicazioni multi-container. Docker Compose consente di definire la configurazione dell’applicazione in un file YAML e di avviare e gestire tutti i container dell’applicazione in modo coordinato.

- Kubernetes: come già detto in precedenza, Kubernetes è una piattaforma di orchestrazione di container che consente di gestire e coordinare l’esecuzione di più container su un cluster di server. Kubernetes offre funzionalità avanzate per il deployment delle applicazioni, come la scalabilità automatica, il rollback delle versioni, la gestione del failover e la gestione del networking e dello storage.

- AWS Elastic Beanstalk: è un servizio di deployment gestito offerto da Amazon Web Services (AWS). Elastic Beanstalk consente di caricare il codice dell’applicazione e di gestire automaticamente le risorse necessarie per l’esecuzione dell’applicazione, come i server, il networking e lo storage.

- Heroku: è una piattaforma di deployment gestito che consente di caricare il codice dell’applicazione e di gestire automaticamente le risorse necessarie per l’esecuzione dell’applicazione, come i server, il networking e lo storage. Heroku supporta numerosi linguaggi di programmazione e framework, tra cui Ruby on Rails, Node.js, Python e Java.

Le tecnologie per il deployment delle applicazioni includono Docker Compose, Kubernetes, AWS Elastic Beanstalk e Heroku. Queste tecnologie consentono di gestire il deployment delle applicazioni in modo coordinato e automatico, semplificando la gestione delle infrastrutture di server distribuiti.